Las armas robóticas aún no existen, pero podrían no estar lejos. Tanto es así que la Organización de las Naciones Unidas está reunida hasta este viernes en Ginebra en la Convención sobre Prohibiciones o Restricciones del Empleo de Ciertas Armas Convencionales. Una reunión para abordar las implicaciones de los Robots Autónomos Letales.

Se especula que estas armas, con capacidad para actuar sin la intervención humana y de adecuarse automáticamente al entorno, podrían nacer en 20 o 30 años más. Pero ya incluso antes de su creación plantean problemas: “podrían violar el derecho internacional humanitario”, señala el profesor de Derecho Internacional de la UC, Hernán Salinas.

En concreto, hay dos principios que no se respetan: el de la distinción y el de la responsabilidad. “Según el derecho internacional”, señala Salinas, “solo se pueden atacar objetivos militares y no civiles; por lo que es difícil que estas armas puedan discriminar entre ambos objetivos”.

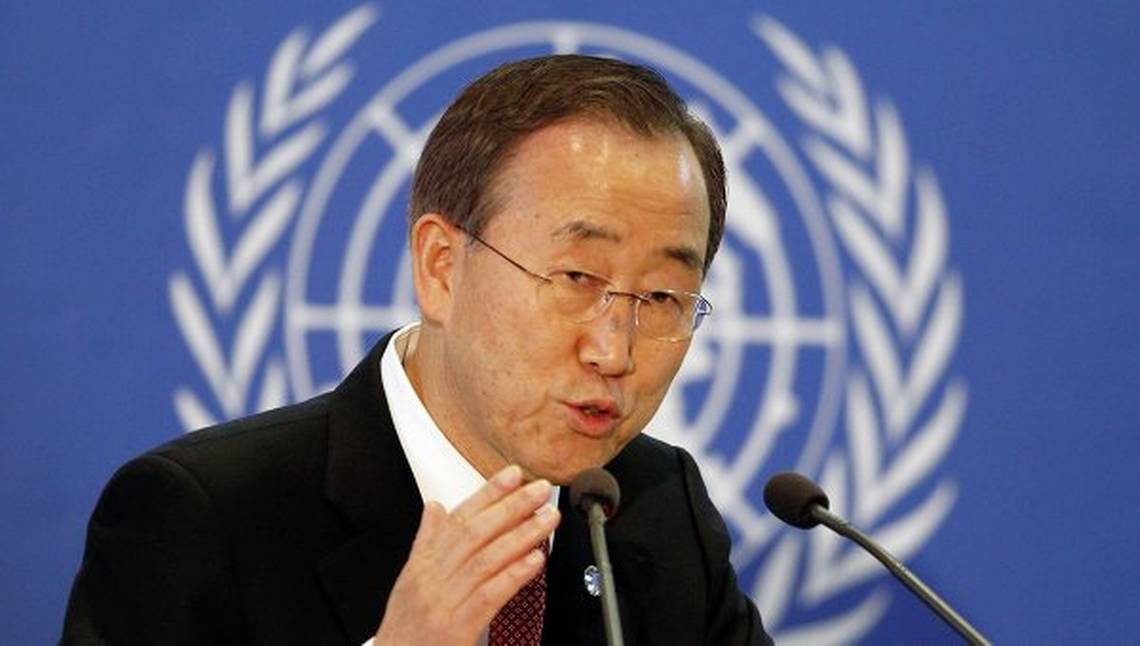

Ya a finales de 2013, el secretario General de la ONU, Ban Ki Moon, alzó su voz contra los robots asesinos. “¿Es moralmente aceptable delegar las decisiones sobre el uso de la fuerza letal en estos sistemas?”, y añadió el secretario, “¿si su uso resulta en un crimen de guerra o una violación de los derechos humanos, quién será legalmente responsable? Si no puede determinarse la responsabilidad, ¿es legal o ético utilizar este tipo de sistemas?".

El derecho internacional contempla también el principio de responsabilidad, pero, en estos casos, “¿a quién se le hace efectivo?”, pregunta el profesor de la Universidad Católica. Un informe conjunto de Human Rights Watch y Facultad de Derecho de Harvard aborda las dificultades para buscar culpables legales que asuman los actos de estos robots.

“El vacío en la rendición de cuentas significa que no hay disuasión para futuros delitos, ni reparación para las víctimas, ni ninguna condenación social del responsable”, señaló Bonnie Docherty, investigadora principal de la división de Armas de Human Rights Watch y autora principal del informe, según se recoge en la web de la propia organización.

En otro informe anterior, ambas organizaciones alertaban del vertiginoso desarrollo tecnológico en la industria armamentística, especialmente de Estados Unidos, Israel, Rusia y Reino Unido, donde los drones van quedando atrás en aras de sistemas más autónomos, señala el documento “Perder la humanidad”.

“Si uno o más países deciden utilizar armas completamente autónomas, otros podrán sentirse obligados a cesar su política de moderación y dar comienzo así a una carrera armamentista para la incorporación de robots de combate” denuncia HRW en su web.

El profesor Salinas aporta otro punto a la discusión y recuerda las armas prohibidas en los conflictos, como las químicas, bacteriológicas o las minas antipersonas. “Habría que ver si este tipo (Robots Autónomos Letales) debieran no crearse por lo mismo, por ser contrarios al derecho humanitario”, señala y agrega que es necesario “regularlas y adecuarlas” a la ley antes de que aparezcan.

Sin embargo, aunque existen “ciertos principios del derecho internacional que regulan la acción en los conflictos armados”, apunta Salinas, “no son suficientes ni adecuados. Falta normativa”, concluye.

La regulación de la que habla el profesor nace de los Estados y de los organismos internacionales como el Comité Internacional de la Cruz Roja o la ONU. Ginebra, sede de múltiples organismos y acuerdos internacionales, tiene estos días un nuevo desafío: decidir entre regular o prohibir antes de que la tecnología militar les tome la vez.

Más información sobre la campaña contra las armas robóticas en: www.stopkillerrobots.org/