La cuarta jornada de Congreso Futuro 2024 estuvo cargada de interesantes charlas. El bloque "LUCES Y SOMBRAS EN LA MÁQUINA" abrió importantes reflexiones sobre el uso de las tecnologías en el presente, los desafíos y lo bueno y malo que pueden conllevar las nuevas herramientas tecnológicas que usamos. Una sección que contó con la charla más divertida de lo que va del evento de divulgación científica más relevante de Latinoamérica.

LEE TAMBIÉN EN CONCIENCIA 24.7:

- Aplicaciones que curan: tecnologías que mejoran la salud mental de los jóvenes

- Congreso Futuro 2024: todo lo que necesitas saber del evento

- Cine con Propósito: narrativas que sensibilizan sobre problemáticas sociales

Martin Hilbert, Doctor en Economía y Ciencias Sociales, y en Comunicación, y referente mundial en Big Data y transformación digital; partió su presentación destacando como la inteligencia artificial se desarrolló en el periodo de la pandemia. Avances que han transformado la tecnología en una herramienta práctica en el último tiempo.

El bien y el mal en el uso de IA: ¿quién se hace responsable?

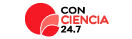

Para Hilbert, quien además coordinó el Programa de la Sociedad de la Información en la Comisión de la ONU para América Latina y el Caribe, esta practicidad se ha hecho evidente con la masificación de ChatGPT, que se ha convertido en la aplicación web que más rápido ha alcanzado los 100 millones de usuarios activos. Un récord mundial que se debe a lo útil que es la app para todo tipo de cosas, según explica el mismo Hilbert, quien ejemplificó su decir con un simple ejercicio: preguntarle a ChatGPT quién era él.

La respuesta fue una visión general de su biografía, pero entre la descripción de ella, se encontraba la siguiente frase: "reconocimientos que le han valido el sobrenombre del Aristóteles Digital".

"Ahí me quedé plop. Por eso me gusta tanto hablar con él (ChatGPT), puro piropo po´ ", contó entre risas Hilbert.

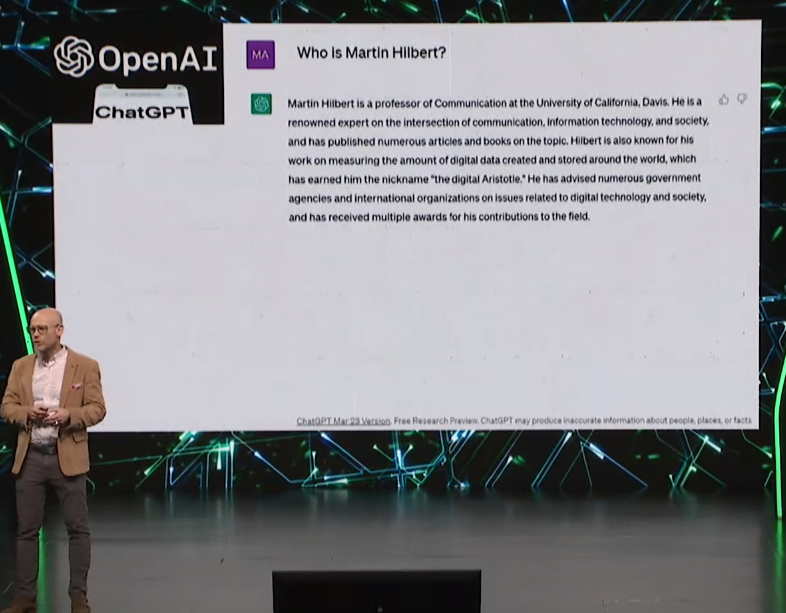

Para comprobar si este sobrenombre había sido usado más veces y si lo que decía ChatGPT era efectivamente real, el experto recurrió a otra IA, DALL-E, una app de generación de imágenes a través de inteligencia artificial. Pensado que la app le entregaría una imagen de él, buscó: "Martin Hilbert", "Aristóteles digital". Pero resultado fue el siguiente:

"Un Aristóteles con tres patas", exclamó con humor Hilbert.

Martin no se desanimó, decidió probar suerte en Google, para ver qué tan verídico era el apodo que le había otorgado ChatGPT. Pero la búsqueda no arrojó ningún resultado. Entonces Martin volvió a ChatGPT para consultarle a la app si le estaba diciendo la verdad.

"Care de raja me contesto no po´ , mi tarea no es contarte la verdad, pero tampoco es decirte una mentira. Mi tarea es sonar cómo humano", explica Hilbert con su tono chilenizado del español, que aprendió cuando vivió en nuestro país hace años atrás.

Maquinas inteligentes

Que la app haya hecho que Martin creyera que lo que leía era cierto, evidencia la verdadera inteligencia de las máquinas y herramientas de esta generación según Hilbert. Alan Turing, uno de los padres de la ciencia de la computación y precursor de la informática moderna, señaló que cuando no logremos distinguir entre un texto creado por un humano y una máquina, debemos aceptar que esta ya cuenta con, al menos, un grado de inteligencia.

Pero la inteligencia de estas herramientas también queda evidenciada en otros parámetros, por ejemplo, los resultados en pruebas de admisión universitaria, según explica el mismo experto. Sólo en EE.UU. el promedio asertividad en las preguntas de la prueba SAT Read & Write de los humanos es de un 65% aproximadamente, mientras que las máquinas tienen un promedio de un 90% aproximadamente.

En la prueba SAT Math los promedios de las máquinas también son significativamente mejores, mientras que en las pruebas de admisión de los doctorados en EE.UU. los resultados también son favorables para las tecnologías. "Hay que cederle a estas herramientas, que por lo menos en eso, son más inteligentes que el promedio de la humanidad", dice Hilbert.

La revolución de la IA

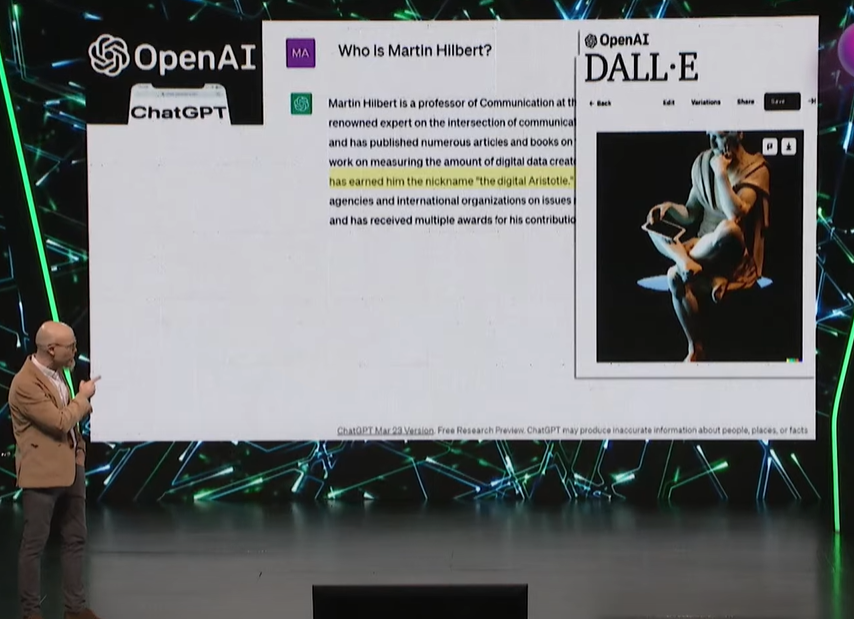

Efectividad de IA que también se traduce a otros ámbitos. GitHub Copilot es una herramienta de inteligencia artificial basada en la nube desarrollada por GitHub y OpenAI para ayudar y asistir a los usuarios de Visual Studio Code, Visual Studio, Neovim y los entornos de desarrollo integrado de JetBrains mediante el autocompletado de códigos. Es decir, una app que entrega sugerencias de estilo de autocompletado a un programador de pares de IA.

Desde que se comenzó a usar, los resultados en términos de bienestar han sido positivos. El 59% de los informáticos que la usan se sienten menos frustrados al codificar, el 60% más realizados con sus trabajos y el 74% considera que se ha podido centrar en labores más satisfactorias debido al uso de la herramienta. Pero estas mejoras mencionadas con IA no sólo son en torno a la tecnología, ejemplos hay para la economía también.

"Los magos de los consultores de la Boston Consulting Group, que cobran mil millones de pesos por una asesoría, han sido reemplazados con una IA que cuesta veinte lucas al mes y que otorga una consultoria con una calidad dos puntos mayor en relación a la de la consultora británica", señala Hilbert.

La educación, la política y la salud también tienen casos en donde la inteligencia artificial ha sido de gran beneficio. De hecho, la misma IA usa otras IA´ s para perfeccionarse y desarrollarse. ¿Entonces, qué nos queda a nosotros los humanos?

Los peligros de la IA: el Godfather, Jeoffrey Hinton

Jeoffrey Hinton es un informático y psicólogo cognitivo conocido por su trabajo sobre redes neuronales artificiales. Hinton fue uno de los primeros en señalar que para crear una IA exitosa, había que simular las redes neuronales del cerebro humano. Por ese entonces nadie le creyó, por lo que vendió su genialidad al mejor postor, Google.

Desde 2013 dividió su tiempo trabajando para en la empresa y la Universidad de Toronto. Una labor que se acabó el año pasado, cuando salió de la empresa citando preocupaciones sobre los riesgos de la tecnología de inteligencia artificial. Se asustó de su propia creación.

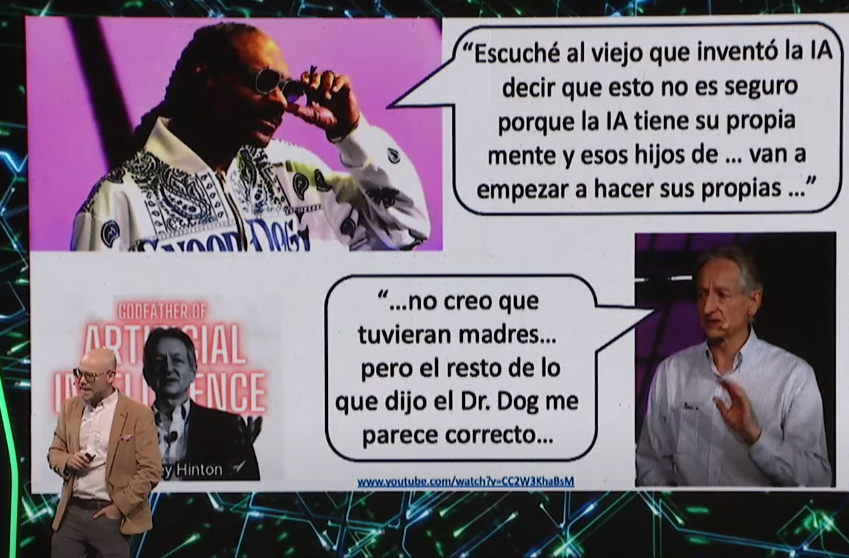

"Escuché decir al viejo que inventó la IA decir que no es segura, porque la IA tiene su propia mente y esos hijos de #$%& van a empezar a hacer sus propias #$%&", frase de Snoop Dogg citada por Martin Hilbert para destacar el peligro que significa la IA.

Más allá de los tonos de humor, la preocupación de Snoop Dogg es justificada y trasladó el público del Centro Cultural CEINA a un espacio de reflexión. Hilbert no se quedó atrás y compartió una anécdota que refleja su enfoque profesional multidisciplinario, que también incluye teoría de la información y análisis del impacto de la digitalización en la desigualdad social, el desarrollo y la metodología científica;

Años atrás, en algún bar de Santiago, Martin se encontraba junto a uno de sus amigos chilenos. En el lugar hablaban mientras compartían cervezas y risas, pero también imaginaban un mundo mejorado por las tecnologías que llegarían en el futuro. Dentro de sus cabezas sabían que los límites no existían, pero también compartían a viva voz que era necesario establecerlos antes de que estos avances llegaran y fuera tarde para regularlos.

Hoy, las tres reglas que eligió Hilbert y su amigo para mantenernos seguros de esta tecnología nos hacen falta: No conectar la tecnología al internet abierto, no dejarla escribir códigos, para que no se mejore a sí misma; y no permitirle interactuar con gente inexperta o vulnerable, como niños o gente con enfermedades mentales. Todas cosas que hacen las IA´ s presentes.

"Hemos avanzado, las alarmas ya están y necesitamos tener manos para mejorar la IA. (...) Ya hemos metido la pata, hemos hecho todo lo que no queríamos hacer. ¿IAhora que hacemos? Literal", dice Hilbert.

Los trabajos de Martin se centran en el impacto que tiene la IA en la conducta y decisiones humanas, enfatizando el uso responsable de esta tecnología y su efecto en la democracia. Por ello, su invitación final estuvo en la importancia de trabajar en conjunto a los poderes judicial, legislativo y ejecutivo para definir límites a la inteligencia artificial. Así, podemos evitar que un algoritmo de Tik Tok haga que un niño de 9 años decida colgarse por cumplir un reto.

Hoy, el 10% de las recomendaciones de los algoritmos son noticias falsas, información peligrosa, sexista o racista. "Si hubiera un producto de consumo que falla el 10% de las veces que se usa, cómo un auto por ejemplo, ¿usted lo usaría?", consulta Hilbert. "Es necesaria una superintendencia de los algoritmos", dice el experto. Una invitación directa a conectarnos más con nosotros mismos, para estar consientes de lo que está pasando en nuestro entorno y para tomarnos valor como humanos.